Inhaltsverzeichnis

Manche Webseiten sind einfach dazu berufen, etwas Größeres zu werden. Sie bieten mehrere tausend Beiträge und nehmen oftmals schon die Form von einem Onlinemagazin an. Oder aber sie ziehen jeden Tag mehrere zehntausend Besucher an und zwingen so den Server regelmäßig in die Knie.

Es ist ein Problem mit dem jeder erfolgreiche Blogger früher oder später einmal konfrontiert wird.

Wir sehen uns daher nun einmal an, was es dazu braucht, damit deine Webseite dauerhaft performant bleibt. Und keine Sorge, so etwas kann man natürlich auch nachträglich noch organisieren!

Sollte man nicht schon von Beginn an auf einen performanten Webspace setzen?

Natürlich ist es immer von Vorteil, wenn man bereits von Grund auf damit rechnet, dass es einmal eine umfangreiche Webseite wird. Nicht immer startet man aber mit einem hohen Budget für den Webspace und so muss jeder mit dem Maximum arbeiten, was ihm zur Verfügung steht.

Im besten Fall weißt du natürlich, wo dich dein Ziel einmal später hinführen wird. Ein Lifestyleblog wird zum Beispiel nicht durch Zufall zu einem Magazin. Irgendwann gibt es einen Punkt, an dem du über diese Wendung nachdenkst und spätestens dann wird es Zeit, alle Vorkehrungen zu treffen, damit deine Seite bereit für den großen Zustrom und die vielen Beiträge ist.

Mit welchen Performanceproblemen ist bei umfangreichen Seiten denn zu rechnen?

Generell hast du es bei umfangreichen Seiten natürlich mit denselben Faktoren zu tun, wie auch bei kleineren Blogs:

- Quellcode

- Datenbanken

- Bilder und Grafiken

- Caching

- Servergeschwindigkeit und -sicherheit

Die Optimierung der Ladezeit ist alleine schon deshalb ein laufender, regelmäßiger Prozess, weil sich die Anforderungen auch andauernd verändern, die deine Seite darstellt. Auch stark optimierte Bilder können daher zum Beispiel zu Ladeverzögerungen führen, wenn tausende von Personen gleichzeitig darauf zugreifen.

Es kommt zu einer Art Hebelwirkung, alles maximiert sich.

Mit steigender Artikelanzahl werden die Einträge in der Datenbank immer voller und auch, wenn nicht alle Beiträge gleich viel Traffic erhalten, so müllt sie irgendwann zu.

Können viele Beiträge WordPress ausbremsen?

Grundsätzlich: Nein.

Content-Management-Systeme wie WordPress & Co. sind ja genau darauf ausgelegt, dass du eine umfangreiche Seite gestaltest, die auch Platz für tausende Beiträge hat, wenn denn der Bedarf dazu besteht.

Wichtig ist in jedem Fall, dass die Datenbank sauber bleibt. Nun wird diese ja von deinem CMS befüllt und allem, was darauf läuft. Also Themes und Plugins. Deine Aufgabe ist es daher, wirklich nur jene zu verwenden, die du brauchst und auf jeden Schnickschnack zu verzichten, der nicht nötig ist.

- Lösche Themes & Plugins, die du nicht mehr benutzt.

- Räum deine Mediathek regelmäßig auf.

- Entledige dich von Spam(-kommentaren).

- Bereinige Tags & Kategorien – was nicht gebraucht wird, kann weg.

- Lösche Entwürfe.

- Lösche Revisionseinträge in deinen Datenbanken. (= Überarbeitungen von Beiträgen)

- Korrigiere fehlerhafte Links.

All diese Dinge spielen sich nicht nur in deinem Editor ab, sondern sollten auch in der Datenbank aufgeräumt werden.

Was viel Arbeitsspeicher frisst, legt diesen dann kurzzeitig für alle anderen Anwendungen lahm. Und so kommt es in weiterer Folge zu Seitenausfällen, weil zu viele Leute gleichzeitig einen gewissen Befehl ausgeführt haben – oder du im Backend zu viele Dinge gleichzeitig tun willst. (Also immer eins nach dem anderen und nicht zehn Beiträge gleichzeitig zur Bearbeitung öffnen!)

Datenbankoptimierung über phpMyAdmin

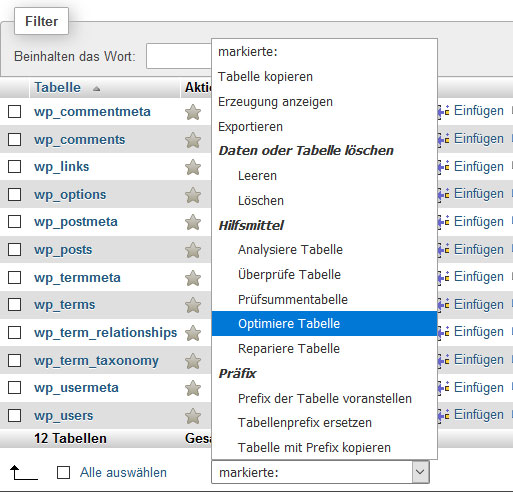

Ein schneller Tipp: Du kannst in phpMyAdmin eine Datenbank auch automatisch optimieren lassen.

Dazu öffnest du die Verwaltung, markierst die betreffende Tabelle und führst dann folgenden Befehl aus:

Wie groß darf die Datenbank maximal sein?

Hier gibt es keine Pauschalantwort, das kommt immer ganz auf den Hoster an und was der Server leisten kann, auf dem deine Datenbank liegt.

Performantes Webhosting muss nicht teuer sein

Dass gutes Webhosting keinesfalls teuer sein muss, stellen die Internethelden gekonnt unter Beweis.

Sie unterscheiden sich in einigen maßgeblichen Punkten vom durchschnittlichen Hoster:

Es gibt eine Begrenzung von Kundenprojekten auf jedem Shared-Webspace-Server.

Dadurch kann garantiert werden, dass man in keine sogenannge “schlechte Nachrbarschaft” gerät, in der das eigene Projekt durch ein umfangreiches anderes lahmgelegt wird, das sich die Ressourcen des Servers mit deinem teilen muss.

Große Projekte bekommen spezielle Zusatzfeatures.

Beispielsweise einen Redis-Cache, der bei vielen parallelen Sitzungen relevant wird (Stichwort Session-Management; wenn dein Blog es deinen Besuchern ermöglicht, sich ein eigenes Nutzerkonto anzulegen) und ElasticSearch, einer sehr schnellen Suche, die bei umfangreichen Seiten von großem Vorteil ist. Etwa, wenn du nach einem bestimmten Inhalt in mehreren tausenden Artikeln suchen musst.

Die Sicherheit des Webspace steht im Fokus.

Es gibt eine serverseitige Firewall, einen Schutz vor DDoS-Attacken und regelmäßige Scans auf Malware. Außerdem werden die Server geo-redundant betrieben. Dadurch erfolgt eine Spiegelung in einem anderen Gebäude. Käme es nun zu einem Brand oder einer anderen Katastrophe, bei der ein Server beschädigt wird, sind die Daten dennoch gesichert.